О.С. Сизов

В 2005 г. окончил Алтайский национальный университет по профессии «эколог-природопользователь». На данный момент — старший инженер направления тематической обработки данных ДЗЗ компании «Совзонд». С мая 2012 г. (по совместительству) — научный сотрудник Университета криосферы Почвы СО РАН.

Кандидат географических наук.

Неприятности применения на практике громадного количества данных связаны с экспоненциальным ростом количества информации в обществе, взявшим наименование «информационный взрыв» (information explosion). Наглядно данный феномен прослеживается на примере роста количества печатных книг в Европе В первую очередь изобретения книгопечатанья в середине XV в. (рис. 1).

Рис. 1. Число печатных книг в Европе (без России и Турции) за 1450–1800 гг., шт.

Сам термин «информационный взрыв» в первый раз упоминается в 1941 г. в словарной статье Oxford English Dictionary [2], а уже в 1944 г. библиотекарь Уэслианского университета (Коннектикут, США) Фремонт Райдер (Femont Rider) публикует работу, в которой приходит к выводу, что число книг в библиотеках американских университетов удваивается раз в 16 лет [3].

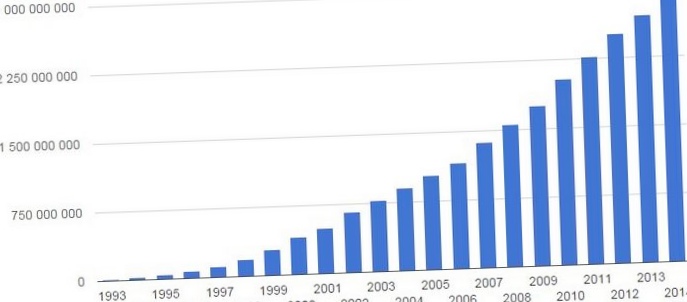

Новый этап информационного развития связан с изобретением ЭВМ, повсеместным переходом к цифровым методам передачи и хранения данных, и с возникновением сети Интернет (рис. 2). По оценке компании Cisco в скором будущем мы вступим в эру зетабайтов (The Zettabyte Era) [4], т.е.

к концу 2016 г. ежегодный IP-трафик преодолеет порог в 1000 экзабайт и будет возрастать на 2 зетабайта в год впредь до 2019 г. (рис. 3)

Рис. 2. Число пользователей сети Интернет, чел. Рис. 3. Прогноз роста интернет-трафика по версии компании Cisco, Tbps

Термин «громадные эти» (big data, BD) в научный оборот в первый раз был введен в 1997 г. инженерами Intel и NASA Майклом Коксом (Michael Cox) и Дэвидом Элсворфом (David Ellsworth), изучавшими проблему визуализации громадных массивов информации [6]. А в 2001 г. аналитик компании Meta Group (поглощена Gartner) Дуглас Лэйни (Doug Laney) представил работу «3D Data Management: Controlling Data Volume, Velocity, and Variety» [7], где внес предложение главные характеристики, которым должны отвечать громадные эти, т.н. «3V»:

- количество (англ. volume, величина физического количества);

- скорость (англ. velocity, как скорость прироста, так и необходимость скоростной получения и обработки результатов);

- многообразие (англ. variety, возможность одновременной обработки разных типов структурированных и полуструктурированных данных).

Довольно часто к трем «V» додают еще одну — Veracity (достоверность), осознавая под этим целостность данных, их свойство к структурированию и уровень доверия к итогам [8].

На данный момент главной поток геопространственной информации, отвечающей неспециализированным параметрам big data, генерируется посредством:

- аппаратуры дистанционного зондирования Почвы, установленной на БПЛА, космических спутниках и самолётах;

- глобальных совокупностей позиционирования (GPS, ГЛОНАСС, Beidou и др.);

- локальных сенсоров, привязанных к определенному объекту либо точке с известными координатами (датчики уровней воды на реках, логгеры метеопараметров, разные датчики мобильных устройств и др.);

- меток радиочастотной идентификации (RFID), установленных на подвижных объектах;

- социальных сетей с географической привязкой контента (Twitter, Facebook и др.) [9, 10].

Также к громадным данным, владеющим пространственной компонентой, либо для краткости «громадным геоданным» (big geo data) возможно отнести целый накопленный архив географических знаний (научные труды, картографические произведения, результаты натурных наблюдений), каковые становятся доступны для анализа в цифровом виде.

Так, лавинообразное накопление громадных массивов данных и интенсификация информационного обмена приводят к происхождению последовательности технологических и методологических неприятностей, ответ которых возможно объединить в рамках единого направления data-driven geography — географических изучений, определяемых данными [11].

ОРГАНИЗАЦИЯ РАБОТЫ С BIG GEO DATA НА ПРИМЕРЕ EOSDIS

Потому, что осознание неприятностей в области управления, анализа, распространения и хранения громадных количеств информации происходило эмпирически по мере развития техвозможностей, наглядно усложнения и процесс развития информационной инфраструктуры возможно продемонстрировать на примере практической реализации программы космического мониторинга Почвы EOS (NASA’s Earth Observing System).

Реализацию программы EOS снабжает совокупность EOS DIS (EOS Data and Information System), основная цель которой пребывает в том, дабы обеспечить сбор, хранение, обработку, предоставление удаленного доступа к каталогам данных справочной информации и мониторинга Земли, и распределение данных исходя из потребностей предельного количества пользователей [12].

На данный момент источником первичной информации являются 22 активные миссии [13], осуществляющие мониторинг всех компонентов природной среды в режиме и глобальном масштабе, приближенному к настоящему времени (рис. 4).

Рис. 4. Временная шкала жизненного цикла научных миссий EOS с 2001 г. (включая планируемые проекты)

По состоянию на сентябрь 2012 г. объем накопленных в совокупности данных составил приблизительно 10 петабйт. Суммарный количество поступающих с целевой аппаратуры космических аппаратов исходных («сырых») данных и продуктов стандартных уровней обработки превышает 8,5 терабайт в сутки. Совокупность снабжает онлайн доступ к более чем 2800 комплектам данных и сервисам для более чем 185000 пользователей на бесплатной базе [14].

Вычислительные потребности совокупности с 2008 г. снабжает суперкомпьютер Pleiades, установленный установленный в NASA Advanced Supercomputing (NAS) исследовательского центра Эймса (NASA Ames). Суперкомпьютер Pleiades при пиковой нагрузке процессоров (11 312 узлов, 211 360 ядер) снабжает скорость вычислений 5.34 петафлопс, количество оперативной памяти образовывает 724 Tb, количество хранилища данных — 1,3 петабайт [15].

Главная цель EOSDIS изначально заключалась в создании совокупности с распределенной открытой архитектурой. EOSDIS версии 0 показалась в августе 1994 года как интегратор совокупностей, каковые имели функциональные возможности управления информацией в семи распределенных центрах-архивах DAAC (Distributed Active Archive Centers) и были связаны через внутреннюю сеть для сотрудничества между собой [16].

На данный момент EOSDIS применяет распределенную архитектуру CINTEX (Catalog Interoperability Experiment), которая разрешает располагать элементы совокупности в разных местах, дабы в большой степени применять разные научные возможности. Для природно-ресурсных спутников EOSDIS предоставляет возможности по управлению, контролю, планированию, сбору данных и начальной обработке (уровень 0) (проект ESMO — Earth Science Mission Operations).

Последующие упрочнения направлены на решение задач тематической обработки данных в ходе проекта Earth Science Data and Information System (ESDIS). Разработка обработки включают: создание научных продуктов более большого уровня (уровень 1–4) для миссий EOS; распространение и архивирование продуктов миссий EOS и других спутников, и данных аэросъемки и полевых измерений. Обобщенная функциональная схема совокупности EOSDIS представлена на рис. 5.

Рис. 5. Функциональная структура EOSDIS

Стандартные продукты уровней 1–4 являются результатами глубокой предварительной либо тематической обработки, подготовленные исходя из потребностей научного сообщества, распределенные в пространстве и/либо во времени и дешёвые, в случае если имеются первичные эти для их создания [12]. В этом отношении, главная изюминка архитектуры EOSDIS пребывает в том, что для ответа задач по программной реализации и научному обоснованию процедур формирования итоговых информационных продуктов привлекаются внешние научные команды на конкурсной базе.

Подобная форма сотрудничества NASA с мировым научным сообществом стала называться — Science Investigator-led Processing Systems (SIPS). Таковой подход разрешает применять самые актуальные и производительные методы обработки разрешённых и обеспечивать большое уровень качества производных продуктов.

Все научные операции SIPS выполняются в рамках распределенной совокупности нескольких взаимосвязанных узлов с конкретными обязанностями для, распределения и архивирования научных данных о Земле. Затем созданные в SIPS продукты направляются в соответствующие DAACs для распространения и архивации [16]. Распределенные центры обработки данных обслуживают сообщество пользователей методом предоставления возможности для поиска, прямого доступа и визуализации к данным и специальным услугам.

Так, в ходе эволюции совокупности EOSDIS в NASA уже в 2007 г. были организованы главные потребности пользователей на новом этапе развития научных данных и вычислительной среды, каковые заключаются в следующем:

- обеспечение общей устойчивой инфраструктуры данных;

- обеспечение больших вычислительных возможностей;

- обеспечение ресурсов для действенного моделирования природных явлений и процессов;

- интенсификация продуктивности научных изучений (способов, инструментов и алгоритмов), как процесса получения новых знаний.

Для реализации появившихся потребностей на данный момент начинается совокупность NASA Earth Exchange (NEX) (рис. 6), которая по сути есть единой платформой для изучений в области наук о Земле, снабжающей:

- вычислительные возможности передового суперкомпьютера Pleiades;

- возможности реализации методов в привычной среде IDL, MatLab, R, Python и др.;

- возможности моделирования природных компонентов, включая предоставление доступа к существующим моделям;

- целый архив дистанционных данных, накопленный в рамках EOS;

- рабочую среду для управления проектом, в которой пользователь может удаленно применять все техвозможности;

- инфраструктуру для распространения взятых результатов, сравнения данных, участия в новых либо существующих проектах и др. [17].

Рис. 6. Динамика числа пользователей в совокупности NASA Earth Exchange (NEX)

ПОДХОДЫ и ОСНОВНЫЕ ПРОБЛЕМЫ ДЛЯ НАУЧНО-ПРАКТИЧЕСКОГО ПРИМЕНЕНИЯ BIG GEO DATA

На примере эволюции совокупности EOSDIS прекрасно видно как по мере накопления все громадных массивов данных происходит адаптация всей информационной инфраструктуры к новым условиям, каковые диктуют необходимость постоянного повышения вычислительных мощностей, перехода к распределенной структуре обработки и хранения, совершенствования измерительной развития и аппаратуры методологического аппарата научных изучений.

И в случае если раньше в условиях централизации источников первичных наблюдений подобные неприятности появлялись лишь применительно к узким отраслевым направлениям, каковые решались силами больших национальных акторов (NASA), то на данный момент возможно сказать о крупномасштабном развитии распределенной сети наблюдений, продуцирующей избыточный информационный поток.

хорошим примером децентрализации наблюдений есть значительное повышение на орбите микро и миниспутников (менее 50 кг), большая часть которых предназначена для мониторинга Почвы (рис. 7). Наряду с этим цена создания, эксплуатации и запуска космических аппаратов сейчас смогут себе позволить не только маленькие государства, но и высокотехнологичные частные компании (Гугл/Skybox Imaging, Planet Labs, OmniEarth и др.).

Рис. 7. Фактический и прогнозируемый рост числа микро- и наноспутнков на орбите

не меньше революционные трансформации происходят и в сегменте беспилотных летательных аппаратов, где разнообразие платформ для личного пользования наровне с широким выбором компактных мульти- и гиперспектральных сенсоров массой не более 2-х кг (Airinov, Micasense, Tetracam, Rikola, HeadWall, Gamaya и др.) создают возможности свободного, своевременного и довольно недорогого сбора высокодетальных пространственных данных для любого заинтересованного пользователя, не обязательно владеющего опытными навыками.

Наряду с этим при применении громадных количеств разных дистанционных данных появляются методологические неприятности, каковые имеют неспециализированные черты с вызовами, установленными для big data [20]. В целом их возможно поделить на три группы:

- «Количество не означает полнота». Неприятности данной группы связаны с техническими изюминками автоматического сбора информации, при котором далеко не всегда удается обеспечить равные количества наблюдений для разных классов объектов либо, в географии, для разных участков земной поверхности. Это указывает, что видимое количество дешёвых космических снимков отнюдь не гарантирует того, что конкретный район будет обеспечен съемкой в необходимый период либо с заданным временным промежутком. Пространственную неравномерность сложно учитывать при проведении конкретных изучений, потому, что в большинстве случаев приоритет отдается задаче, т.е. сперва происходит постановка задачи, а после этого уже идет сбор дешёвой информации. Исходя из этого в изучениях, определяемых данными (data-driven geography), список дешёвых для ответа задач может значительно отличаться от списка фактически значимых задач.

- «Количество не означает чистота». Для big data преобладание а также доминирование несортированных данных над сортированными есть непременным условием. При дистанционных изучениях на стадии проектирования сенсора имеется возможность минимизировать количество шума, устранить механические погрешности аппаратуры, совершить калибровку. Но кроме того при корректной работе аппаратуры существует много внешних действий, каковые делают взятую данные негодной для применения на практике. Оценка пригодности данных и удаление информационного шума не имеет возможности опираться только на автоматизированные методы, за исключением очевидных случаев (наличие облачности, снежного покрова). Исходя из этого для большинства задач обязан формироваться личный комплект параметров проверки качества с учетом базы знаний в каждой тематической области (учет фаз вегетации растительности, гидрологического цикла водных объектов и т.п.). Такая проверка, например, может строиться на базе сочетания логических и семантических правил [11].

- «Корреляция не означает обстоятельство». Статистические способы анализа громадных массивов данных смогут ошибочно приводить к обнаружению корреляции логически не связанных явлений. В этом отношении довольно часто видятся примеры связи между сокращением числа и глобальным потеплением пиратов (рис. 8) [21] либо развития депрессии у людей, укушенных кошками [22]. Автоматическая классификация космических снимков способами без обучения кроме этого обычно ведет к объединению пикселей, имеющих сходные значения яркости, но логически относящихся к разным типам земной поверхности. Наряду с этим полученные результаты смогут отыскать только ограниченное использование на практике в силу не сильный сопоставимости кроме того с результатами, взятыми на базе снимка за другую дату либо снимка с отличающимися техническими параметрами.

Рис. 8. Зависимость глобального потепления от числа пиратов

Однако, научно-практическое внедрение способов data-driven geography, по всей видимости, вопрос ближайшего будущего. Их сложно разглядывать как альтернативу классическим способам получения новых знаний, скорее они воображают интерес при ответе таких задач как:

- первичный анализ и сбор данных, постановка рабочей догадки;

- визуализация разных типов пространственных данных;

- моделирование процессов с учетом теоретических и логических построений [9[.

С данной точки зрения возможно предложить неспециализированные подходы, каковые смогут уменьшить процесс работы с big geo data в рамках ответа определенной исследовательской задачи:

- Стандартизация измерительной аппаратуры – применительно к любым типам датчиков и сенсоров (включая БПЛА, наземные устройства и логгеры, устанавливаемые in situ) должны использоваться процедуры, подтверждающие заявленную корректность и точность приобретаемых первичных данных. Это разрешит значительно сократить упрочнения по структурированию, валидации и фильтрации.

- Стандартизация метаданных и форматов – кроме того для маленьких проектов и единичных исследований нужно предусматривать передачи и возможности хранения итоговой информации на базе самый распространенных стандартов, что сократит в будущем упрочнения по унификации базы знаний для ответа подобных задач.

- Историчность изучений – исполнение нужных действий по переводу и сбору в цифровой вид любой архивной информации (базы знаний), которая была накоплена по заданному объекту. сочетание результатов и Ретроспективный анализ, взятых на базе разных способов, разрешит распознать неточности и в том и другом случае.

- Алгоритмизация — представление накопленной базы знаний по каждой отраслевой задаче (знания экспертов, логические правила, результаты ранее выполненных работ и др.) в унифицированном виде (выделение необходимых технологических блоков обработки данных, определение параметров самопроверки и др.).

- Сходимость и воспроизводимость результатов — применение разных данных, алгоритмов и моделей при автоматизированном ответе конкретной задачи, что разрешит оценить достоверность взятых результатов, выяснить процент погрешности и воспроизвести итог в будущем при необходимости.

Так, без оглядки на наличие отдельных методологических вопросов, существуют подходы, каковые разрешают реализовать новые возможности обработки громадных пространственных данных, что, в конечном итоге, выводит географические изучения на более производительности и высокий уровень точности.

ВОЗМОЖНОСТИ ИЗУЧЕНИЙ НА БАЗЕ BIG GEO DATA

Новый уровень географических изучений в методологическом замысле связан прежде всего с синергией и интеграцией абдуктивных, индуктивных и дедуктивных подходов при ответе тематических задач и получении новых предметных знаний [23].

В методическом отношении применение способов data-driven geography разрешает сказать о переходе к «правильной географии», где для каждого участка земной поверхности с погрешностью определения и заданной размерностью положения, смогут быть организованы комплекты данных по каждому компоненту природной среды на определенный момент времени. Наряду с этим по мере накопления разрешённых будут формироваться временные последовательности, на базе которых покажутся возможности детального моделирования динамики геопроцессов.

Технологический и информационный прорыв, что стал причиной увеличению и децентрализации количества источников первичной географической информации, в возможности значительно ускорит интеграционные процессы, а также в вопросе обмена данными исследований. В частности, это соответствует одному из правил наибольшей сети персональных метеостанций Weather Underground — «совместно мы знаем больше (Together We Know More) [24].

Возможно также подчернуть, что с развитием «персонализации» географических изучений формируется громадной круг задач, в которых способы data-driven geography смогут взять большое использование. Среди таких задач — навигация (сервисы общедоступных треков), создание открытых карт (проект OpenStreetMap), мониторинг экстренных обстановок (краудсорсинг при поиске пропавших летательных аппаратов), идентификация объектов (проект Wikimapia, сервисы геопозиционированных фотографий, панорамы улиц) и др.

Так, анализ литературы [14, 25] и результаты исследования разрешают выделить главные условия перехода к научно-практической работе с big geo data, в числе которых:

- Оборудование (разработки): обеспечение большой скорости выполнения и вычислительной мощности методов сбора, анализа, хранения и передачи громадных количеств структурированных и не хорошо структурированных данных;

- Методика (изучения): при обнаружении закономерностей —создание аналитического инструментария с опорой на методологический аппарат, созданный и апробированный для каждой сферы деятельности;

- Задачи (приложения): постановка ясных задач для машинного анализа с привлечением отраслевых экспертов, снабжающих корректное формирование обучающей выборки данных и обнаружение настоящих связей.

- Образование (познание): модернизация образовательных программ исходя из современных технологических возможностей анализа данных, что разрешит адекватно подготовить будущих экспертов для работы в новой информационной парадигме.

Визуально сочетание обрисованных выше условий возможно представить в виде неспециализированной схемы организации изучений, предложенной в рамках развития совокупности EOS (рис. 9).

Рис. 9. Структурная схема организации научной деятельности в совокупности EOS

ПЕРЕЧЕНЬ ЛИТЕРАТУРЫ

- Eltjo, B., Luiten, J.Z. (2009) Charting the «Rise of the West»: Manuscripts and Printed Books in Europe, A Long-Term Perspective from the Sixth through Eighteenth Centuries», The Journal of Economic History, Vol. 69, No. 2, 409-445.

- http://www.forbes.com/sites/gilpress/2013/05/09/a-very-short-history-of-big-data/

- Rider, F. (1944) The Scholar and the Future of the Research Library. New York City: Hadham Press.

- The Zettabyte Era: Trends and Analysis / Cisco Visual Networking Index (VNI): Forecast and Methodology, 2014–2019. http://www.cisco.com/c/en/us/solutions/collateral/service-provider/visual-networking-index-vni/VNI_Hyperconnectivity_WP.pdf

- http://www.internetlivestats.com/internet-users/

- Cox, M., Ellsworth, D. (1997) Application-controlled demand paging for out-of-core visualization. In Proceedings of the 8th conference on Visualization ’97 (VIS ’97). IEEE Computer Society Press, Los Alamitos, CA, США, 235-ff.. https://www.nas.nasa.gov/assets/pdf/techreports/1997/nas-97-010.pdf

- Laney, D. (2001) 3D Data Management: Controlling Data Volume, Velocity, and Variety, Technical report, META Group. http://blogs.gartner.com/doug-laney/files/2012/01/ad949-3D-Data-Management-Controlling-Data-Volume-Velocity-and-Variety.pdf

- «What is Big Data?». Villanova University. http://www.villanovau.com/resources/bi/what-is-big-data/#.VfLqMBHtlBc

- Miller, H. J. (2010). The data avalanche is here. Shouldn’t we be digging? Journal of Regional Science, 50(1), 181–201

- Sui, D., Goodchild, M. F. (2011). The convergence of GIS and social media: Challenges for GIScience. International Journal of Geographical Information Science, 25(11), 1737–1748.

- Miller H., Goodchild M. (2015) Data-driven geography. GeoJournal, Vol. 80, Iss. 4, 449-461. DOI: 10.1007/s10708-014-9602-6

- https://earthdata.nasa.gov/

- http://eospso.gsfc.nasa.gov/content/all-missions

- Science Plan for NASA’s SMD 2007-2016. NASA Headquarters, 2007. 170. http://science.nasa.gov/media/medialibrary/2010/03/31/Science_Plan_07.pdf

- http://www.nas.nasa.gov/hecc/support/kb/entry/77

- Maiden M. (2011) Philosophy and Architecture of the EOS Data and Information System // Remote Sensing and Digital Image Processing. Springer New York. 35-47. http://dx.doi.org/10.1007/978-1-4419-6749-7_2

- NASA 2014 Science Plan. NASA Headquarters, 2014. 123. http://science.nasa.gov/media/medialibrary/2015/06/29/2014_Science_Plan_PDF_Update_508_TAGGED.pdf

- https://nex.nasa.gov/nex

- Low Earth Orbit Satellite Volume Set to Rapidly Expand. Earth Imaging Journal. 8 October 2014. http://eijournal.com/news/industry-insights-trends/low-earth-orbit-satellite-volume-set-to-rapidly-expand

- Mayer-Schonberger, V., Cukier, K. (2013). Big Data: A revolution that will transform how we live, work, and think.

- Henderson, B. (2005). Open Letter To Kansas School Board. Venganza.org. http://www.venganza.org/about/open-letter/

- Hanauer, D., Ramakrishnan, N., Seyfried, L. Describing the Relationship between Cat Bites and Human Depression Using оптимальнее an Electronic Health Record, PLoS ONE, vol. 8, no. 8, 2013, e70585.

- Gahegan, M. (2009). Visual exploration and explanation in geography: Analysis with light. In H. J. Miller J. Han (Eds.), Geographic data mining and knowledge discovery (2nd ed., pp. 291-324). London: Taylor and Francis

- http://www.wunderground.com/about/background.asp

- Boyd, D., Crawford, K. (2012) Critical Questions for Big Data. Information, Communication Society. Vol. 15, Iss. 5, 2012. DOI:10.1080/1369118X.2012.678878

Hadoop Everywhere geo distributed storage for big data

Интересные записи на сайте:

- Система городского мониторинга топографических планшетов и использование цмр для городских нужд

- Особенности автоматической потоковой обработки данных кмсс космического комплекса «метеор-3м»

- Системы services engine на платформах envi и idl: достижение максимальной эффективности*

- Аэрофотосъемка. разновидности аппаратов

- Космический радарный мониторинг смещений земной поверхности над нефтегазовым месторождением тенгиз

Подобранные по важим запросам, статьи по теме:

-

В росноу прошла международная научная школа исследование космоса: теория и практика

Tweet 2-3 сентября в Русском новом университете (РосНОУ) прошла Интернациональная научная школа Изучение космоса: практика и теория. Школа была…

-

Образцы паразитизма научной бюрократии

Александр Просвирнов Ежегодные затраты на содержание главного офиса организации ИТЭР составляют 240 млн. евро. Российская Федерация из собственной квоты…

-

Научный спутник «чибис-м» в июле из-за сбоя остался без электропитания

РИА Новости. Российский научный спутник «Чибис-М» в последних числах Июля из-за ошибочной команды оказался без света — аппарат вышел в «надёжный режим»,…

-

В фиане прошла научная сессия памяти а.д. сахарова

25 мая в Физическом университете им. П.Н. Лебедева РАН (ФИАН) состоялась Научная сессия Отделения физических наук РАН, посвященная 90-летию со дня…

-

Сапцин владимир михайлович, научная биография

Сапцин Владимир Михайлович, к.ф.-м.н., высшей кафедры математики и доцент информатики КГУ им. М.В. Остроградского, появился в 1951 г. в Кременчуге…

-

Обзор первой в мире безотходной научно-исследовательской станции в антарктиде. часть 1

Вам думается, что в том месте, где вы на данный момент находитесь, холодно? Выдалась жёсткая зима? На научной станции Принцесса Элизабет (Princess…