ИИ уже везде и везде останется. Многие нюансы нашей жизни в той либо другой степени касаются ИИ: он решает, какие конкретно книги приобрести, какие конкретно билеты на авиарейс заказать, как успешны поданные резюме, предоставит ли банк какое лекарство и ссуду от рака назначить больному. Многие его применения по отечественную сторону океана еще не пришли, но в обязательном порядке придут.

Все эти вещи — и многие другие — сейчас смогут в значительной мере определяться сложными программными совокупностями. Огромные удачи, достигнутые ИИ за последние пара лет, поразительны: ИИ делает нашу жизнь лучше во многих, многих случаях. Рост ИИ стал неизбежным. Огромные суммы были инвестированы в стартапы на тему ИИ. Многие существующие технические компании — включая таких гигантов, как Amazon, Facebook и Микрософт, — открыли новые исследовательские лаборатории.

Не будет преувеличением заявить, что ПО сейчас свидетельствует ИИ.

Кое-какие предвещают, что пришествие ИИ будет таким же громадным событием (либо кроме того больше), как и появление Интернета. BBC опросила специалистов, что готовит данный скоро изменяющийся мир, наполненный блестящими автомобилями, нам, людям. И что особенно весьма интересно, практически все их ответы были посвящены этическим вопросам.

Питер Норвиг, директор по изучениям в Гугл и пионер машинного обучения, считает, что технологии ИИ, основанные на данных, поднимает особенно серьёзный вопрос: как обеспечить, дабы эти новые совокупности улучшали общество в целом, а не только тех, кто ими руководит.

«ИИ был очень действенным в практических задачах — от маркировки фотографий до понимания речи и письменного естественного языка, обнаружения болезней», говорит он. «Сейчас задача пребывает в том, дабы удостовериться, что любой пользуется данной разработкой».

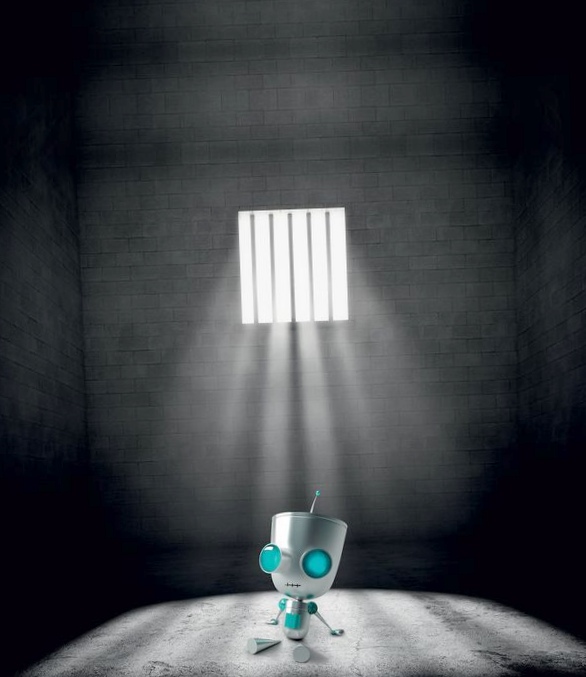

Громадная неприятность содержится в том, что сложность ПО обычно свидетельствует, что нереально определить, из-за чего совокупность ИИ делает то, что делает. Благодаря тому, как трудится современный ИИ — основываясь на обширно успешной технике машинного обучения, — нереально капот и взглянуть, как он трудится. Исходя из этого нам приходится легко ему доверять.

Задача пребывает в том, дабы придумать новые методы мониторинга либо аудита многих областей, в которых ИИ играется громадную роль.

Джонатан Зттрейн, доктор наук интернет-права юридического факультета Гарварда, считает, что существует опасность того, что усложнение компьютерных совокупностей может помешать нам в обеспечении контроля уровня и должного проверки.

«Меня тревожит сокращение автономии человека, потому, что отечественные совокупности — при помощи разработок — становятся все более сложными и тесно взаимосвязанными», говорит он. «В случае если мы «настроим и забудем», мы можем пожалеть о том, как разовьется совокупность и что не разглядели этический нюанс ранее».

Это беспокойство разделяют и другие специалисты.

«Как мы сможем сертифицировать эти совокупности как надёжные?», задаёт вопросы Мисси Каммингс, автономности Лаборатории и директор человека в Университете Дьюка в Северной Каролине, одна из первых дам-пилотов истребителя ВМС США, сейчас эксперт по беспилотникам.

ИИ потребуется надзор, но пока остается под вопросом, как это сделать.

«На данный момент у нас нет общепринятых подходов», говорит Каммингс. «И без промышленного стандарта тестирования таких совокупностей будет тяжело обширно имплементировать эти технологии».

Но в быстро изменяющемся мире обычно и органы урегулирования выясняются в позиции догоняющих. Во многих ответственных областях наподобие здравоохранения компании и уголовного правосудия уже наслаждаются эффективностью ИИ, что принимает ответ об условно-досрочном освобождении либо диагностике заболевания. Передавая право решения автомобилям, мы рискуем утратить контроль — кто будет контролировать правоту совокупности в каждом отдельном случае?

Дана Бойд, основной исследователь Микрософт Research, говорит, что остаются важные вопросы о сокровищах, каковые записываются в такие совокупности — и кто в конечном счете несет за них ответственность.

«Регуляторы, социальные теоретики и гражданское общество все чаще желают видеть эти технологии честными и этическими, но их концепции в лучшем случае расплывчаты».

Одна из областей, чреватых этическими проблемами, это рабочие места, по большому счету рынок работы. ИИ разрешает роботам делать все более непростые работы и вытесняет много людей. Китайская Foxconn Technology Group, поставщик Apple и Samsung, заявила о намерении заменить 60 000 рабочих завода роботами, а фабрика Ford в Кельне, Германия, поставила роботов рядом с людьми.

Более того, в случае если увеличение автоматизации окажет громадное влияние на занятость, это может иметь негативные последствия для психологического здоровья людей.

«В случае если задуматься о том, что дает людям суть в жизни, это три вещи: значимые отношения, значимая работа и страстные интересы», говорит Иезекиель Эмануэль, биоэтик и бывший советник по вопросам охраны здоровья Б. Обамы. «Значимая работа — очень важный элемент чьей-то идентичности». Он говорит, что в регионах, где работы были утрачены вместе с закрытием фабрик, увеличивается риск суицида, злоупотребления психоактивными веществами и депрессии.

В следствии мы видим потребность много экспертов по этике.

«Компании будут направляться своим рыночным стимулам — это хорошо, но мы не можем надеяться на то, что они будут вести себя этически корректно просто так», говорит Кейт Дарлинг, эксперт по этике и праву в Массачусетском технологическом университете. «Мы видели это всегда, в то время, когда оказалась новая разработка и мы пробовали сделать вывод, что с ней делать».

Дарлинг отмечает, что многие компании с большими именами, такие как Гугл, уже создали надзорные комитеты по этике, каковые осуществляют контроль развёртывание и разработку их ИИ. Имеется вывод, что они должны быть более распространенными.

«Мы не желаем душить инновации, но такие структуры нам легко нужны», говорит она.

Подробности о том, кто сидит в совете по этике Гугл и чем занимается, остаются туманными. Но в прошлом сентябре Facebook, Гугл и Amazon запустили консорциум для разработки ответов, каковые разрешат совладать с пропастью ловушек, которые связаны с секретностью и безопасностью ИИ. OpenAI — также организация, которая занимается продвижением и разработкой ИИ с открытым исходным кодом на благо всех.

«Принципиально важно, дабы машинное обучение изучалось открыто и распространялось через открытые публикации и открытый исходный код, дабы все мы имели возможность поучаствовать в дележе вознаграждений», говорит Норвиг.

В случае если мы желаем развивать этические стандарты и промышленность и наряду с этим четко осознавать, что поставлено на карту, то принципиально важно создать мозговой штурм с участием экспертов по этике, разработкам и фаворитов корпораций. Речь заходит о том, дабы не просто заменить людей роботами, а оказать помощь людям.

Почему этическая проблема самая серьезная для искусственного интеллекта

Интересные записи на сайте:

- Глава nasa: экипаж мкс обеспечен необходимым продовольствием, ему ничто не угрожает

- Нейромедиаторы, часть вторая: аденозин, ацетилхолин, глутамат и гамма-аминомасляная кислота

- Запущен первый в россии образовательный онлайн курс о персонализированной медицине

- Искусственно созданная форма жизни озадачила ученых

- Новые подробности об алмазном аэрогеле

Подобранные по важим запросам, статьи по теме:

-

Почему искусственный интеллект не должен быть человекоподобным?

ИИ многогранная и непростая задача? Отнюдь нет. В чем же тогда загвоздка? Из-за чего мы сидим и обсуждаем, а в мире до сих пор кроме того гиганты IT…

-

Термин «искусственный интеллект» потерял всякий смысл

Довольно часто это легко актуальное наименование компьютерной программы В научной фантастике возможность угрозы ИИ (ИИ) связана с взаимоотношениями людей…

-

Как искусственный интеллект учится на наших привычках и обманах

В большинстве случаев дабы обнаружить преступность в Сети, онлайн, необходимо знать, что искать. ИИ, что видит скрытые схемы, паттерны, может делать это…

-

Четыре основных отличия потребительского искусственного интеллекта от производственного

В случае если вас попросят представить ИИ для промышленности и производства, вы, вероятнее сперва поразмыслите о роботах. Множество инновационных…

-

Священнослужители об искусственной клетке

Американский ученый Дж. Крейг Вентер сказал, что сумел сконструировать живую клетку, применяя неестественную ДНК . Иными словами, человек в первый раз…

-

Почему виртуальная реальность — это killer app для блокчейна

Создатель материала выходит за рамки привычных для отечественного платежного блокчейн-сервиса Wirex тем, посвященных распределенным разработкам в…